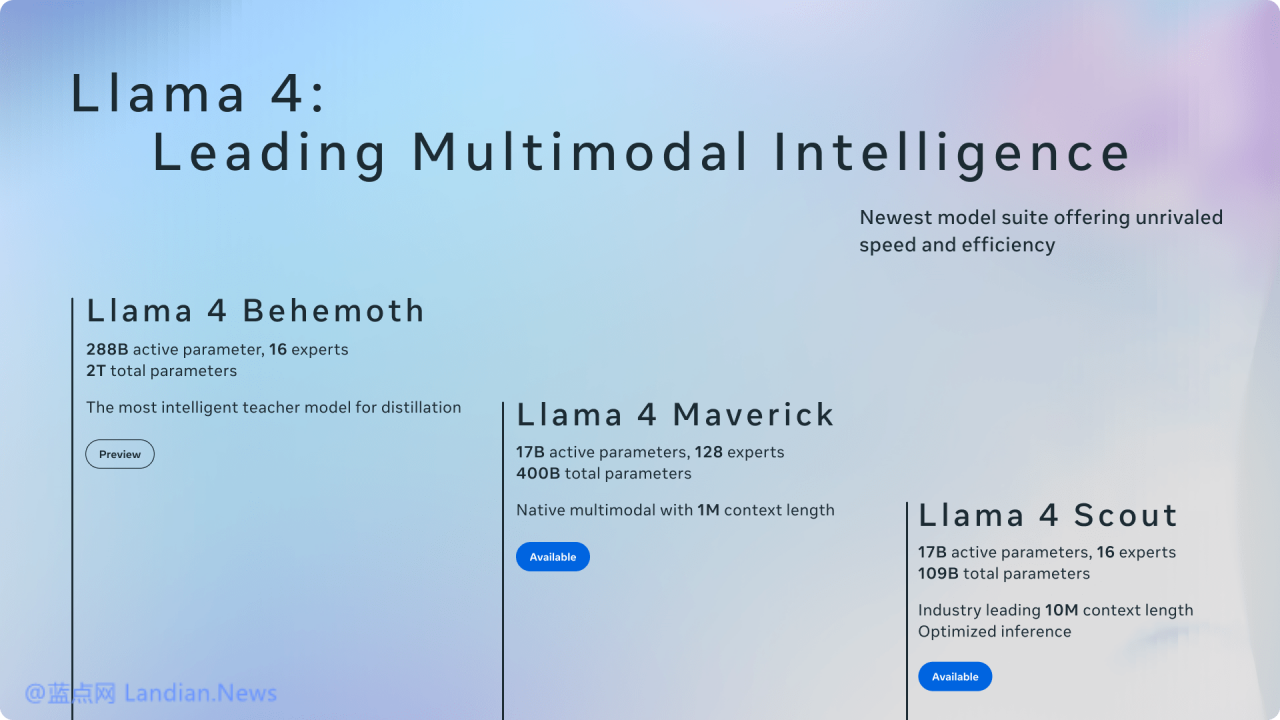

Meta 推出 Llama 4 系列人工智能模型 拥有 1,000 万上下文窗口 能力超越 GPT-4o

社交媒体集团 Meta 日前宣布推出其最新的 Llama 4 系列开放人工智能模型,这些模型可以通过 Meta 或 HuggingFace 下载,暂时提供的包括 Llama 4 Scout 和 Llama Maverick,Llama 4 Behemoth 还在训练中。

Llama 4 Scout 号称能够在单个 Nvidia H100 GPU 上运行,该模型拥有 1000 万个 token 上下文窗口,在多种基准测试中表现超过谷歌的 Gemma 3、Gemini 2.0 Flash-Lite 以及开源的 Mistral 3.1

Llama 4 Maverick 的表现则是超过 GPT-4o 和 Gemini 2.0 Flash,编程和推理任务的能力则与 DeepSeek-V3 相当,只需要使用不到一半的活动参数 — 是的,Meta 也转向 MoE 混合专家模式。

Meta 表示 Llama 4 转向 MoE 混合专家架构,通过这种架构仅使用模型中特定任务所需要的部分来节省资源,Meta 将在 4 月 29 日举办的 LlamaCon 会议上讨论 AI 模型和产品的未来计划。

对于旗舰模型 Llama 4 Behemoth 目前还在开发中,该模型拥有 288B 活跃参数,总共则包含 2T 参数(两万亿),Meta 透露该模型在多个 STEM 基准测试中超越竞争对手的 GPT-4.5 和 Claude Sonnet 3.7。

尽管 Meta 将 Llama 系列模型称之为开源模型,但需要注意的是 Meta 有自己的许可证,例如对于每月活跃用户超过 7 亿名的商业实体使用该模型前必须向 Meta 申请许可,所以该系列模型最多只能说是开放模型,而非开源模型。

![[多区域] RackNerd特价服务器促销:10.98美元/年 3T流量/月 1G带宽](https://img.lancdn.com/landian/2024/10/106203T.png)